近日,复旦大学义乌研究院董必勤研究员团队,联合华中科技大学、上海交通大学共同研发了FAST(FrAme-multiplexed Spatio-Temporal learning)深度学习框架。该成果以“Real-time self-supervised denoising for high-speed fluorescence neural imaging”为题,发表于Nature Communications(中科院1区,IF=15.7)。

生物医学高速成像技术的核心困境在于“时间分辨率”与“图像信噪比”之间的固有矛盾。对毫秒级事件的“实时”捕获,要求将曝光时间压缩至极限,这造成了严重的“光子预算”不足。光子流强度的显著降低,最终表现为原始数据中难以避免的强噪声,限制了图像的可用性与定量分析的准确性。传统的降噪算法或复杂的深度学习模型虽然能提升信噪比,但其计算量巨大,无法满足每秒上千帧的实时处理需求,成为“边观察边分析”实验的主要障碍。

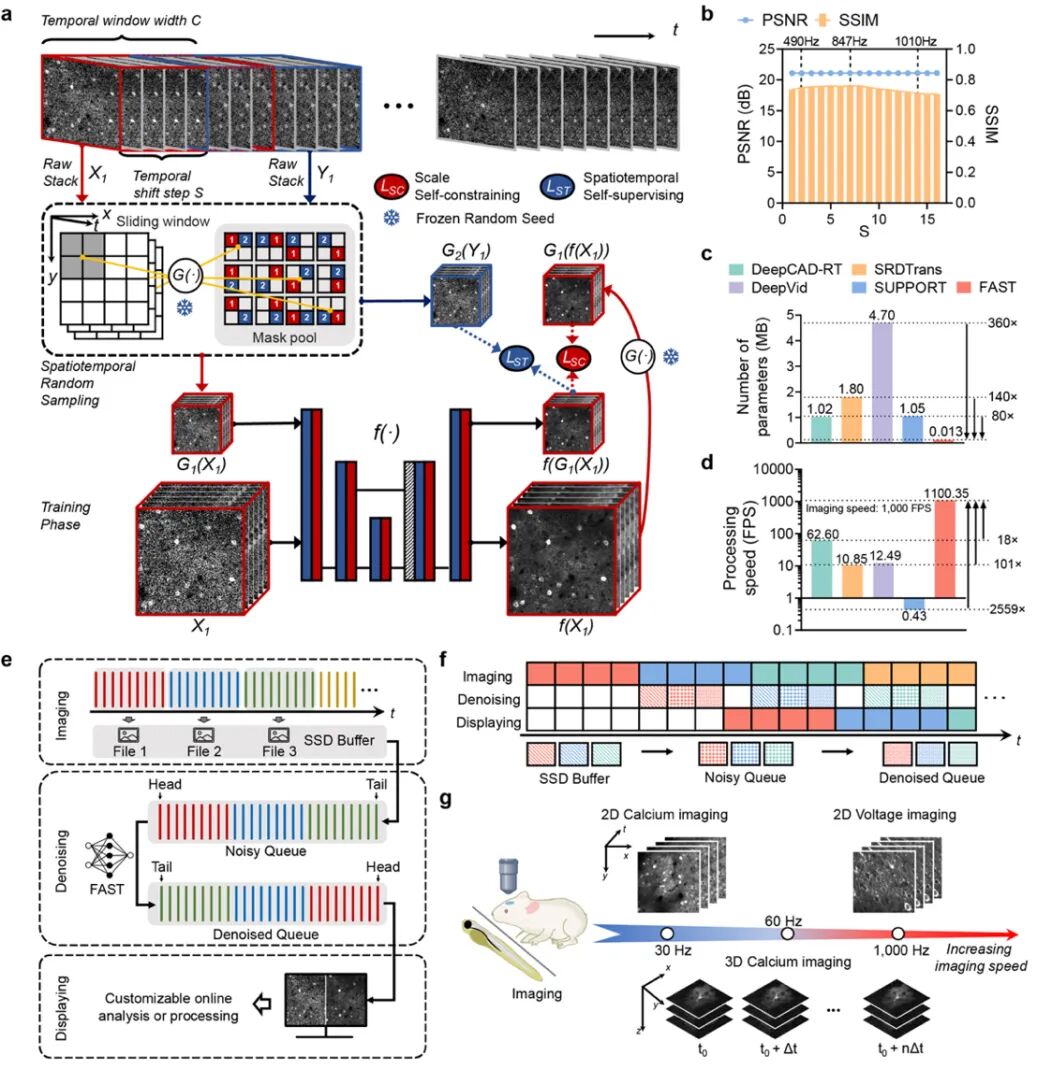

FAST框架的核心,是一种创新的自监督学习策略,即“帧复用时空采样”,通过独特的采样方式,使网络能够高效利用相邻像素的空间信息和时间信息,减少了对数据时间连续性的依赖。这种设计巧妙地避免了传统医学影像降噪方法中常见的信号失真和过度平滑等问题。使FAST得以采用一个极度轻量级的2D卷积网络,其参数量仅为0.013M,远小于传统复杂的降噪模型。极简的网络结构和高效的数据利用方式,是FAST实现高速与高质量降噪并存的关键。该框架在无“纯净”数据监督的条件下,即可对帧率逾1000fps的高速光学成像序列实施实时降噪,为前沿生命科学应用提供了“即采即清”的成像新范式。

本论文成果主要依托复旦大学义乌研究院“智能生物医学光子成像学科产业化项目”,融合了光学、电子信息与人工智能等交叉学科工作,致力于自主研制世界领先的多光子显微与全息光遗传刺激技术,实现介观尺度全光脑机接口设备的产业转化落地。

原文链接:

https://www.nature.com/articles/s41467-025- 64681-8

END